Tag 1: Anforderungen an die IT, Cloud- und Datamanagement

Obwohl man heute, wenn es um Daten geht, vom modernen Gold spricht, wird es kümmerlich bewirtschaftet. Gerade mal 7.3% der Firmen nutzen die eigenen Daten im Tagesgeschäft. Die grösste Herausforderung ist die richtige Anwendung sowie die Bewirtschaftung «guter» Daten. Vielfach sind Daten vorhanden, jedoch nicht in einem auswertbaren Zustand.

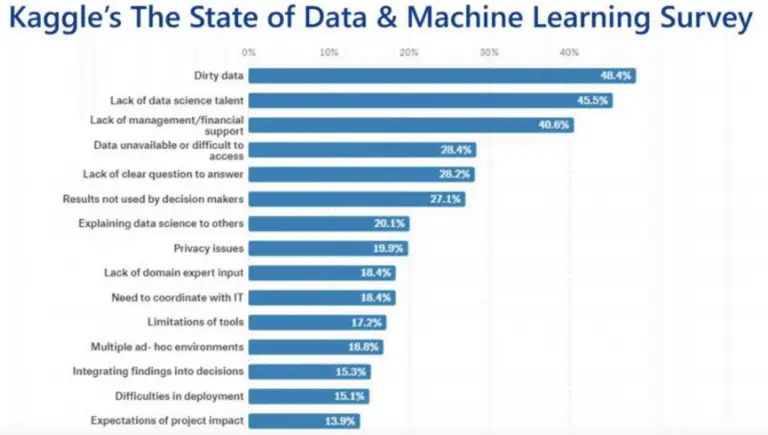

Datenqualität ist entscheidend – Quelle: Kundenbefragung von Kaggle aus dem 2020

Es zeigt, dass es mit dem Umgang mit den Daten grosse Herausforderungen zu meistern gibt.

Was sind Data Driven Organisationen? Es sind solche, die anhand der erhobenen Daten gewisse Ereignisse vorhersagen können (Bsp. Sensoren in Maschinen, die eine wackelnde Schraube erkennen können oder Analyse der Aufträge, die den Geschäftsverlauf abschätzen können, usw.).

Man kann nur erfolgreich mit Daten arbeiten, wenn eine Datenkultur vorhanden ist. D.h. die beteiligten Personen müssen wissen, warum und wozu die Daten verwendet werden. Die Menschen aus den Abteilungen müssen immer mit an Bord sein, sonst funktioniert das nicht.

Daten begründete Entscheide können die Führungskultur beeinflussen. Das ist gerade da herausfordernd, wo die Meinung der Geschäftsleitung eine andere ist, als das die Daten zeigen. Firmen, wie Spotify haben sogenannte Self-Service Analytics Berater, die nichts anderes machen, als andere im Unternehmen zu befähigen, die im Business generierten Daten auszuwerten.

Datenverarbeitung am Beispiel der BKW AG (Smart Metering)

Gastreferent Daniel Koch zeigt anhand der Firma BKW wie man die Zähler in den Haushalten, die man heute noch von Hand ausliest durch neue intelligente Smart Meter Zähler, die vernetzt sind, ersetzt.

Daniel Koch, Leiter Netznutzungsmanagement bei der BKW AG, Bern

Bis 2028 müssen sämtliche analoge Zähler auf intelligente Smartmeter-Zähler umgestellt sein. Dies bedeutet, dass eine komplett neue Business-Architektur erstellt werden muss und neue Prozesse in der kompletten Datenverarbeitung eingeführt werden müssen.

Künftig wird der Kunde jederzeit online seinen Energieverbrauch einsehen können. Gleichzeitig werden Teilzeitjobs als Zählerableser*in komplett verschwinden. Dabei sind die grössten Herausforderungen folgende:

- Jederzeit die richtigen Mitarbeitenden am richtigen Ort involvieren

- Parallelbetrieb alter und neuer Systeme und Prozesse

- Motivation der Mitarbeitenden trotz Abbau und Veränderungen

Data Management Maturity

Hier geht es um die Klärung der Frage, wie weit oder wie reif mein Unternehmen in Bezug auf die Daten und Digitalisierung schon ist. Zudem unterstützt es das Unternehmen auf dem Weg hin zu einem neuen SOLL-Zustand. Das DMM-Modell soll auch helfen, ein gemeinsames Verständnis über die Erhebung, Verwaltung und Archivierung der Daten zu entwickeln.

Das Open Data Maturity Modell beinhaltet 5 Levels. Anhand dieser Levels kann man den Reifegrad seines Unternehmens einschätzen und festlegen, worin und wohin man sich im Datamanagement verbessern will.

Tag 2: Business Process Analytics und Process Mining

Predictive Analytics (Frühzeitige Erkennung)

Welche Fragen sollen mithilfe von Daten beantwortet werden? Die Daten müssen kontextualisiert werden, bevor man zuverlässige Voraussagen machen kann. Voraussagen beziehen sich nicht nur auf die Zeit (Zukunft), sondern auf fehlende Informationen. Ein weiteres Hilfsmittel für die Vervollständigung von Daten sind sogenannte Proxies. Beispiel: Corona Fallzahlen vs. Google Suchtrends nach «Geschmacksverlust». Die Suchtrends haben viel früher den Hinweis auf die Krankheit geliefert, als die effektiv gemessenen Fallzahlen.

Prescrtptive Analytics (Präventive Erkennung)

Hier geht es um die Frage: Wie kann ich ein System beeinflussen, damit das gewünschte Resultat erreicht wird. Beispiel: Ich frage mich nicht, ob es morgen regnet, sondern brauche ich einen Regenschirm? Will ich diesen den ganzen Tag herumschleppen?

Es geht darum, Fragen zu beantworten, bei dem ein Bedürfnis oder Verhalten beeinflusst werden soll. Hier hilft eine Aggregation (Einteilung in Sektionen) der Daten.

Vier Typen der Business-Analyse (Gartner Maturity Modell)

Die meisten Anwendungsfälle sind sogenannte Narrow-AI (Spezifisches Können wie Bilderkennung, Sprecherkennung). Dem gegenüber steht das General-AI, welches verschiedene Disziplinen und Intelligenzen in sich kombiniert hat.

Supervised Learning (Kontrolliertes Lernen)

Diese Methode versucht eine Vorhersage auf einer Datenbasis zu modellieren. Beispiel, wie wahrscheinlich ist es, dass ein Patient Diabetes hat, wenn er bestimmte Voraussetzungen (Alter, Gewicht, BMI, Schwangerschaften) erfüllt. Basierend auf diesen Angaben, kann eine Wahrscheinlichkeit errechnet werden:

Supervised Learning mit BigML am Beispiel einer Diabetes-Diagnose

Der Algorithmus versucht die verschiedenen Werte aus den Datensätzen zu analysieren und in Gruppen und Kategorien zu separieren.

Experten System vs. predictive Applikation

Das sind fix programmierte Systeme, die tagtäglich bedient und gefüttert werden (Bsp: CRM). Dem gegenüber steht eine predictive Applikation, der anstelle eines Experten durch einen Algorithmus ersetzt wird. Die Vorteile sind:

- die Daten sind genauer

- erkennt Muster zuverlässiger

- weniger Aufwand, da man nicht laufend neue Regeln programmieren muss

- es sind mehr Iterationen ohne Programmierer möglich

Klassische Programmierung versus Machine Learning (Quelle: straitstimes.com, Stand: 12.10.21)

Der Machine Learning Workflow besteht aus drei Phasen:

- Data Präparation (Erheben & strukturieren der Daten)

- Modelling (BigML – Training, Test, Evaluation, Vorhersage)

- Operating (Integration ins Tagesgeschäft)

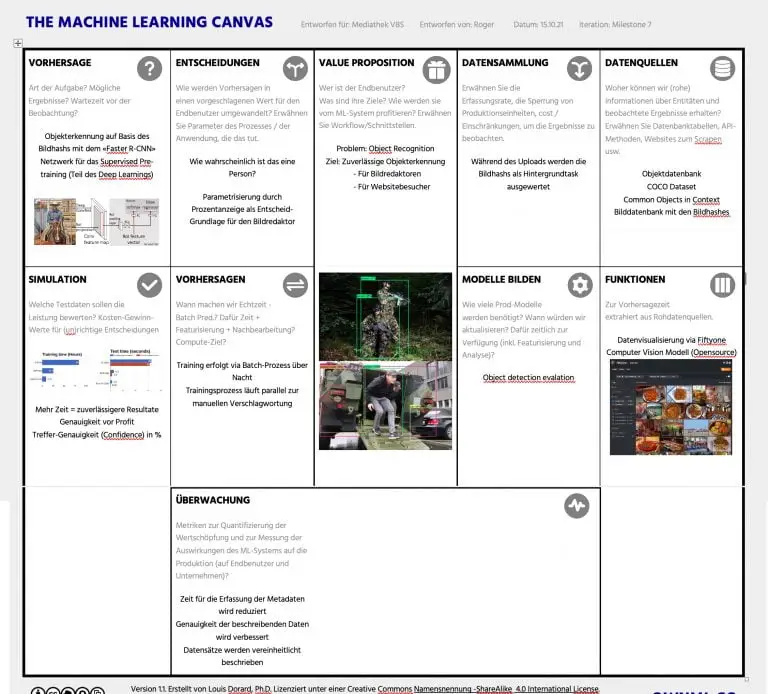

Der Machine Learning Canvas

Die Struktur des ML-Canvas besteht aus vier Elementen:

- Goal/Ziel: Nutzerversprechen (Was, warum, wer?)

- Predict/Vorhersage: Was ist das Datenproblem und was sind die Anforderungen an die Vorhersagen?

- Lernen: Was braucht es, um das ML-Problem zu lösen?

- Evaluate/Auswertung: Methoden und Bewertungen wie gut die Qualität der Ergebnisse ist.

Machine Learning Canvas von Louis Dorard (Quelle: machinelearningcanvas.com, Stand: 12.10.21)

Tag 3: Realtime Analytics & Business Process Monitoring

Typische Flaschenhals Probleme für den Einsatz von ML

Es gibt verschiedene Engpässe, die eine zuverlässige Vorhersage verhindern:

- falsche Daten (Labeling, Human in the Loop)

- unvollständige Daten (Labeling, Human in the Loop)

- Ausreisser im Modell (Anomalien)

- politische, gesellschaftliche Veränderungen (Black Swan Theorie)

- fehlende Schnittstellen (wie komme ich an die Daten ran)

- fehlendes Know-How

- falsche Annahmen

- Personelle Engpässe (Data Scientist)

- Datenschutz – Restriktionen

Data Transformations (Umwandlung)

80% des Aufwands für ML/Supervised Learning sind die korrekte Aufbereitung der Daten. Nur wenn die vorgängig beschriebenen Flaschenhals-Probleme reduziert werden, ist es möglich, zuverlässige Regeln zu extrahieren.

Es gibt verschiedene Methoden, solche Daten in die richtige Form und Struktur zu bringen:

- mehrere kleine Tabellen in einer Grossen zusammenführen (Denormalising)

- Gleiche Merkmale zusammennehmen (Aggregation)

- Daten zueinander in Relation setzen (Pivoting)

- Vergleichen von Daten innerhalb eines Zeitfensters (Time-Windows)

Unsupervised Learning (Auswertung ohne Labeling)

Unsupervised Learning arbeitet nicht mit Labels so wie das Supervised Learning, sondern mit Clusters. Es sucht nach Ähnlichkeiten und Merkmalen im Datensatz. Gewisse Merkmale werden zu einer Gruppe (Cluster) zusammengefasst. Aufgrund der Eigenschaft eines Cluster wird eine Vorhersage abgeleitet.

- Welche Kundengruppe hat die gleiche Eigenschaft (Segmentierung)?

- Wie viele Gruppen mit den gleichen Eigenschaften gibt es?

Unsupervised Learning, Clusterbildung mit BigML am Beispiel von Whisky-Sorten

Idealerweise kann man Unsupervised Learning benutzen, um gewisse Zusammenhänge zu erkennen. Daraus lassen sich in einem nächsten Schritt bestimmte Daten «labeln». Dadurch wird eine Auswertung mit Supervised Leraning möglich.

Darstellung im Topic Model (Themenmodell)

Bei der Topic Model Analyse werden bestimmte Theman als weiteres Analysekriterium herausgefiltert.

Topic Modell mit BigML am Beispiel der Hotelbewertungen

Dank den Topic Models können neuen Attribute für das bestehende Dataset erstellt werden. Dank dieses Vorgehens können neue Auswertungen ermöglicht werden. Jetzt fragt man sich, was ist der Unterschied zwischen der Clustering-Methode und dem Topic Modell?

Clustering funktioniert nur bei numerischen und kategorischen Datenfeldern. Beim Topic Modell können auch individuelle Textinhalte zusammengesetzt werden.

Lessons learned

- Data Driven Organisationen sind produktiver

- Data Driven bedeutet ein breites Datenverständnis zu haben

- Daten bedeuten Macht und werden nicht so ohne weiteres weitergegeben (Datenkultur)

- Sich der Gefahr Daten falsch zu interpretieren (Data Lineage) bewusst sein

- Korrelation und Kausalität sind entscheidend für die richtigen Schlussfolgerungen aus den erhobenen Daten

- Datensicherheit: Cyber Security wird massiv an Bedeutung zunehmen

- Machine Learning gibt Regeln aus, anstatt Antworten

- Bei ML geht es um die Fragen: Was (Vorhersagend, predictiv), warum (Diagnostik, Kausalität)?

- 80% des Aufwands entsteht bei der Datenaufbereitung